Hace unos meses, OpenAI, el operador de ChatGPT financiado por Microsoft, despidió a su consejero delegado, Sam Altman. Después de cinco días de caos con los popcorn-emoji, lo volvieron a contratar. La repentina medida, de la que el multimillonario inversor Microsoft sólo se enteró momentos antes de que se hiciera pública, parece haber surgido de una pelea entre Altman y el ingeniero Ilya Sutskever, encargado de la «alineación» en la empresa. La facción de Sutskever, incluida la miembro del consejo Helen Toner, cuya disputa con Altman puede haber precipitado estos acontecimientos, está fuera. Larry Summers, ex secretario del Tesoro y presidente de Harvard, que dudaba de que las mujeres fueran buenas en ciencia, está dentro. El regreso de Altman implicó que, en una lucha entre ganancias y seguridad, triunfaron las ganancias..

¿O quizá ganó la seguridad? OpenAI es una empresa extraña, y sus estatutos renovados reafirman su objetivo original: salvar a la humanidad de la propia tecnología que están inventando.

Ambas partes en esta lucha creen que la inteligencia artificial general («AGI», o inteligencia a nivel humano) está cerca. Altman dijo, el día antes de ser despedido, que «cuatro veces» —una en las últimas semanas— había visto a los científicos de OpenAI empujar «el velo de la ignorancia hacia atrás y la frontera del descubrimiento hacia delante». A Sutskever le preocupa que los agentes de IA formen megacorporaciones con un poder sin precedentes, dirige a los empleados en el cántico «¡Siente la AGI!», y al parecer quemó una efigie de una AGI «no alineada» para «simbolizar el compromiso de OpenAI con sus principios fundacionales». Toner procede de la Universidad de Georgetown a través del Future of Humanity Institute de la Universidad de Oxford, un destacado instituto de investigación para la perpetuación de la ideología de la pseudociencia ficción dirigido por el filósofo Nick Bostrom.

La cuestión, en este ambiente, no es si las máquinas son inteligentes, sino si hay que acelerar el desarrollo y la distribución de esta AGI potencial —la postura de Altman— o frenar en seco: el aparente deseo de Sutskever.

Este debate saltó a la luz pública y puso de manifiesto el conflicto entre los denominados catastrofistas de la inteligencia artificial (IA) y los aceleracionistas. La cuestión de los agoreros es cuál es la probabilidad de extinción, su evaluación de «p(doom)». El economista Tyler Cowen señaló que los doomers no respaldan su creencia en la absorción de la IA con apuestas reales sobre este resultado, pero si decenas de miles de millones de dólares penden de este tipo de lucha, es difícil verlo como algo sin importancia. El objetivo que surge de este cóctel de ciencia y creencia religiosa en la inteligencia artificial es «alinear» la inteligencia de las máquinas con los valores humanos, de modo que, si adquieren sensibilidad, no puedan hacernos daño.

«Alineación», nos dice el autor Brian Christian, fue tomado prestado por la informática del discurso de la «ciencia de la gestión» de la década de 1980, donde la provisión de incentivos para crear una corporación «alineada con los valores» estaba de moda. Los economistas han señalado que la «alineación directa» con una única institución es radicalmente diferente de la «alineación social», que es en lo que se centra OpenAI. El grupo de Sutskever llama a su proyecto «superalineación», elevando aún más la apuesta retórica. Pero esto no es más que humo, y revela una terrible incomprensión de la propia tecnología que pregonan estos líderes empresariales e ingenieros.

Karl Marx dijo que el capitalismo parecía sencillo pero en realidad albergaba «sutilezas metafísicas y sutilezas teológicas». Sin embargo, no hay nada sutil ni agradable en lo que está ocurriendo en la empresa de la IA, y no estamos haciendo un gran trabajo para contrarrestarlo con la crítica. Los acontecimientos de OpenAI de esta semana son un gran ejemplo de lo que yo considero «metafísica en la alta dirección»: un debate desquiciado y alejado de la realidad que impulsa decisiones con precios de mercado altísimos y consecuencias potenciales reales y peligrosas.

El concepto de alineación es un castillo de naipes que se desmorona inmediatamente cuando se revelan sus supuestos. Esto se debe a que cada intento de enmarcar la alineación se basa en una concepción de fondo del lenguaje o del conocimiento que es «neutral en cuanto a los valores», pero nunca lo hace de forma totalmente explícita. Uno sospecha que esto se debe a que la neutralidad de los valores, y por tanto la propia «alineación», no tiene una definición real. Tanto si piensas que lo bueno son las máquinas imparciales como si te defiendes de una máquina que aprende a matarnos, básicamente estás pasando por alto el hecho de que la IA ya es un reflejo de los valores humanos reales. El hecho de que eso no sea bueno o neutral debe tomarse mucho más en serio.

Hay toda una industria dedicada a la seguridad de la IA, y gran parte de ella no tiene que ver con la metafísica. No es que no pase nada. Todos leemos a diario sobre los muchos y aterradores males de nuestros sistemas automatizados. Frenar el daño real es importante, no me malinterpreten. Simplemente no está claro que la «alineación» pueda ayudar, porque no está claro que sea un concepto en absoluto.

El debate sobre la alineación no empezó con la IA generativa. Cuando Google descubrió cómo hacer que los ordenadores produjeran un lenguaje con sentido, una de las primeras cosas que la máquina escupió fue la idea de que las mujeres debían ser amas de casa. Los científicos presentes en la sala en aquel momento, según informa Christian, dijeron: «Eh, aquí pasa algo». Esta idea nociva les horrorizaba, pero no sabían qué hacer. ¿Cómo conseguir que un ordenador te hable —algo que ahora damos por sentado con el auge del ChatGPT— pero que también se ajuste a valores como la igualdad? El objetivo de la alineación es como la famosa ley de la robótica de Isaac Asimov, que impide que las máquinas hagan daño a los humanos. Sesgo, falsedad, engaño: estos son los daños reales que las máquinas pueden hacer a los humanos hoy en día, por lo que alinear la IA parece un problema acuciante. Pero lo cierto es que la IA está muy alineada con los valores humanos, sólo que no soportamos admitirlo.

Bostrom, que dirige el Future of Humanity Institute, dominó gran parte de la conversación sobre la alineación con su experimento mental del «sujetapapeles», en el que una IA diseñada para maximizar la producción de sujetapapeles se da cuenta de que la capacidad humana de desactivar la propia IA pone en peligro su misión, se aísla de la intervención humana y, en algunas versiones, extermina a la raza humana. Esta historia desempeñó un papel importante en la ética de la IA, influyendo en figuras como Stuart Russell (una de las principales voces en la ética de la IA). Los clips de Bostrom son también una de las principales razones por las que la idea de la IA como «riesgo existencial» —el riesgo de extinción humana, que Bostrom impulsa en la mayor parte de sus escritos— llegó a los titulares nacionales. Pero la idea no es más que un disparate, ciencia ficción sin la rentabilidad literaria ni la perspicacia social de una novela futurista. Y lo que es peor, no tiene nada que ver con la IA a la que nos enfrentamos hoy en día. Este tipo de pensamiento se desarrolla totalmente en un modo contrafactual, aunque su marco básico informa la mayor parte del pensamiento actual sobre la IA.

La otra gran fuerza del debate público sobre la IA no se centra en la fatalidad, sino en el daño. Su idea principal es que la IA «generativa» es un «loro estocástico» que remezcla el lenguaje humano y reproduce sus prejuicios. Los enormes conjuntos de datos en los que se entrenan estos algoritmos son «insondables», lo que convierte la alineación en un objetivo imposible. Y sin embargo, estos críticos de la IA también operan con una noción implícita de alineación, simplemente negándola en lugar de promoviéndola. La lingüista Emily Bender, por ejemplo, sostiene que los conjuntos de datos lingüísticos presentan una imagen desigual y sesgada del lenguaje humano porque se extraen de lugares como Reddit, donde predominan las voces masculinas. Sin duda, esto es un problema, pero no está claro dónde se encontraría un lenguaje «no sesgado», o incluso si existe. Entre las soluciones sugeridas está el «diseño de valores» que atienda a voces y contextos locales y marginados. Pero no existe un «local» tan pequeño que haga desaparecer la naturaleza intrínsecamente conflictiva del valor, las normas de las que surge el sesgo.

Si sumamos Reddit, cientos de miles de libros, Wikipedia y una tonelada más de sitios de la World Wide Web, se forma una instantánea mental de los datos de entrenamiento. Pero, como deja claro el artículo sobre el loro estocástico, esa instantánea es realmente «insondable», demasiados datos como para darle algún sentido mental. Para empezar, no hay ninguna medida cuantitativa del sesgo en el lenguaje. Paradójicamente, la «falta de alineación» podría ser inextricable del lenguaje. Si ese es el caso, entonces la IA está captando el sesgo cultural a una escala sin precedentes. Sólo que ver ese sesgo expuesto ante nosotros es feo e inquietante y, como bien señala Bender, amplificarlo es malo.

La tercera fuerza importante en la alineación es la convicción de que los problemas con la IA generativa provienen específicamente de la falta de «arraigo». Yann LeCun, considerado uno de los «padres fundadores» de la nueva IA, es el que más se pronunció al respecto. Sostiene que los grandes modelos lingüísticos como ChatGPT y LLaMA nunca dirán la verdad —una capacidad crucial para cualquier alineación posible— hasta que fundamenten sus «juicios» en la percepción.

El llamado «problema de la alucinación», en el que la IA inventa precedentes jurídicos ficticios o da respuestas perversamente perjudiciales a quienes buscan ayuda, surge, según LeCun, porque los modelos lingüísticos no conocen el mundo. Su lenguaje no se basa en la percepción, que, en opinión de LeCun, es la forma en que los humanos se hacen una idea de cómo funcionan las cosas. Pero la informática Ellie Pavlick respondió señalando que el «fundamento» no es tan sencillo. Por ejemplo, los precedentes jurídicos no se basan en la percepción visual. Ningún conocimiento del mundo basado en el sentido común puede sumarse a la complejidad del lenguaje humano. Al fin y al cabo, los chatbots no inventaron la desinformación ni las estafas: las inventamos nosotros.

Todo esto lleva a una conclusión clara: la alineación es un problema mal concebido. El valor de los debates sobre la alineación de la IA consistió en gran medida en mostrarnos lo que el lenguaje y la cultura humanos no son. No son «neutrales en cuanto a valores», no se ajustan a ningún conjunto de normas supuestamente comunes y no se basan en pruebas o percepciones científicas. No existe un punto de vista «neutral» desde el que evaluar la alineación, porque el problema es en realidad de valores, que es algo por lo que nos peleamos, donde no hay una respuesta correcta.

Un punto central estadístico para cualquier valor dado, aunque pudiera alcanzarse, no es una solución a ningún problema que no sea encontrar el propio punto central estadístico. El problema, incluso con las críticas mejor intencionadas de estos sistemas, es que asumen un punto de vista arquimédico —desde el que «se podría mover el mundo entero», como decía el filósofo— sobre un objeto vago, algo así como «todo el lenguaje» o «toda la cultura». Nadie puede adoptar ese punto de vista, tanto si cree en la IA como si quiere abolirla.

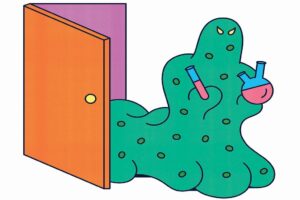

Hablar de alineación siempre viene acompañado de un «nosotros». Queremos que la IA nos dé resultados iguales, o un discurso imparcial, o información verdadera. No está nada claro que Altman y Sutskever representen un «nosotros» colectivo y democrático en este sentido. Sin embargo, es igualmente difícil ver cómo exactamente un «nosotros» democrático puede regular este monstruo cultural para ponerlo en línea. Sin embargo, el equilibrio entre el gobierno y las empresas no funcionó durante décadas, y la IA se está beneficiando del dominio social del capital. Engullir la cultura, la ciencia y la geopolítica era siempre el siguiente paso.

El problema de la alineación queda perfectamente reflejado en lo sucedido en OpenAI. Es un concepto pseudofilosófico que implica un conocimiento perfecto de los «valores» humanos y sociales. Pero en términos pragmáticos, es un objetivo, no una idea. Y ese objetivo, aunque esté envuelto en un discurso sobre la seguridad impulsado por delirios metafísicos, es la comercialización de la IA.

La IA, si no sus defensores, ya nos refleja un «nosotros» con gran precisión. Esos científicos de Google podrían haber tenido una reacción diferente ante la misoginia del algoritmo. Podrían haber dicho: ¡vaya, nuestro lenguaje colectivo alberga misoginia! Averigüemos qué significa eso. En lugar de pasar a un concepto mal definido de «alineación», quizá deberían —y deberíamos— habernos dado cuenta de que tenían en sus manos una herramienta sin precedentes para comprender los prejuicios, la cultura y el lenguaje. Al fin y al cabo, un ordenador que escupe frases misóginas sólo es un problema si se pretende comercializarlo como producto.

Visto así, el concepto de alineación es una ilustración perfecta de la ideología. Theodor W. Adorno pensaba en la ideología como una verdad realmente falsa. Ese es el tipo de cosa que es la alineación: es cierto que la IA puede estar e incluso está alineada con nosotros, debido a la forma en que está entrenada. El objetivo mismo de dotar a la IA de un conjunto de normas que de algún modo coincidan con las nuestras es falso, no sólo incorrecto sino también erróneo. El «nosotros» de la IA es esta contradicción y el mundo en el que tenemos que vivir como resultado de ella, no una articulación utópica —o agorera— de «valores».

Lo racional sería desconectar estos robots y utilizarlos para estudiar nuestros prejuicios, la composición de nuestras ideologías y la forma en que el lenguaje funciona e interactúa con la computación. No contenga la respiración.